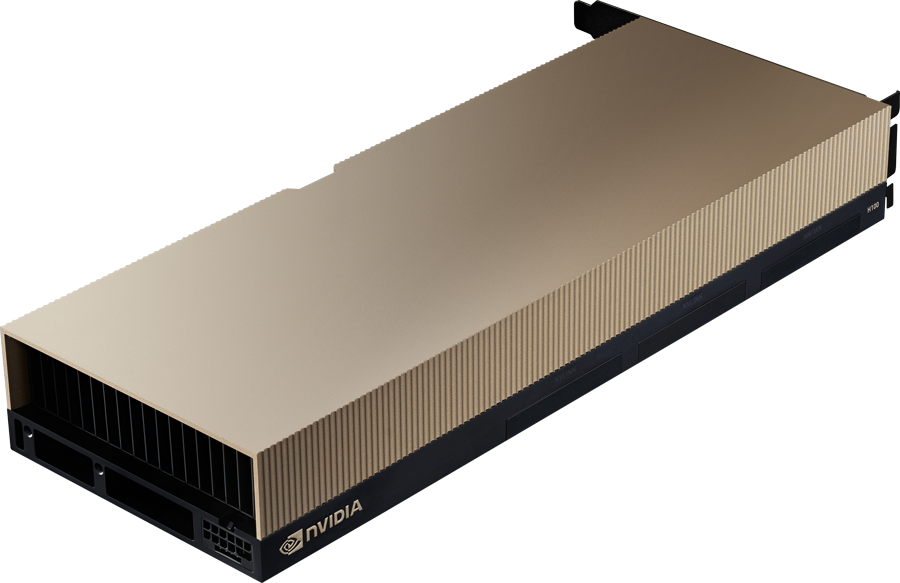

NVIDIA H100 NVL

Procesor graficzny NVIDIA® H100 NVL z rdzeniami tensorowymi umożliwia skok o rząd wielkości w przypadku wielkoskalowej sztucznej inteligencji i HPC, oferując niespotykaną wydajność, skalowalność i bezpieczeństwo w każdym centrum danych, a także zawiera pakiet oprogramowania NVIDIA AI Enterprise usprawniający rozwój i wdrażanie sztucznej inteligencji.

Najbardziej zaawansowany chip na świecie

Zbudowany z 84 miliardów tranzystorów przy użyciu najnowocześniejszego procesu TSMC 4N, dostosowanego do potrzeb akcelerowanych obliczeń firmy NVIDIA, H100 NVL jest najbardziej zaawansowanym chipem na świecie.

Architektura NVIDIA Hopper

Procesor graficzny NVIDIA H100 NVL oparty na architekturze GPU NVIDIA Hopper zapewnia kolejny ogromny skok wydajności obliczeniowej dla platform centrów danych. H100 bezpiecznie przyspiesza różnorodne obciążenia, od obciążeń małych przedsiębiorstw, przez eksaskalowe HPC, po modele AI o bilionach parametrów.

Rdzenie tensorowe czwartej generacji

Nowe rdzenie tensorowe są do 6 razy szybsze w porównaniu do rdzeni w GPU A100. W przeliczeniu na SM zapewniają 2 razy większą wydajność obliczeniową MMA (Matrix Multiply-Accumulate) niż A100 SM na równoważnych typach danych i 4 razy większą niż A100 przy użyciu nowego typu danych FP8, w porównaniu z FP16 w poprzedniej generacji. Funkcja Sparsity wykorzystująca kompresję rzadkich macierzy w sieciach głębokiego uczenia jeszcze podwaja wydajność standardowych operacji rdzeni tensorowych.

Silnik transformera doładowuje sztuczną inteligencję, do 30 razy wyższą wydajność

Transformer Engine wykorzystuje oprogramowanie i niestandardową technologię Hopper Tensor Core zaprojektowaną specjalnie w celu przyspieszenia szkolenia modeli zbudowanych z najważniejszego na świecie bloku konstrukcyjnego modeli AI, transformera. Rdzenie tensorowe Hopper mają możliwość stosowania mieszanych 8-bitowych formatów zmiennoprzecinkowych (FP8) i precyzji FP16, aby radykalnie przyspieszyć obliczenia AI dla transformerów.

Nowe instrukcje DPX

Programowanie dynamiczne to algorytmiczna technika rozwiązywania złożonego problemu rekurencyjnego poprzez rozbicie go na prostsze podproblemy. Programowanie dynamiczne jest powszechnie stosowane w szerokim zakresie przypadków użycia. Na przykład Floyd-Warshall to algorytm optymalizacji tras, którego można użyć do mapowania najkrótszych tras dla flot wysyłkowych i dostawczych. Algorytm Smitha-Watermana jest używany do wyrównywania sekwencji DNA i składania białek. Hopper wprowadza instrukcje DPX w celu 40-krotnego przyspieszenia algorytmów programowania dynamicznego (instrukcje DPU 40-krotnie w porównaniu z CPU) w porównaniu z procesorami CPU i 7-krotnie w porównaniu z procesorami graficznymi opartymi na architekturze NVIDIA Ampere. Prowadzi to do radykalnego skrócenia czasu diagnozowania chorób, optymalizacji tras w czasie rzeczywistym, a nawet analityki grafów.

Ulepszone funkcje pracy asynchronicznej

Nowe funkcje wykonywania asynchronicznego obejmują nową jednostkę Tensor Memory Accelerator (TMA), która może bardzo wydajnie przesyłać duże bloki danych między pamięcią globalną a pamięcią współdzieloną. TMA obsługuje również kopie asynchroniczne między blokami wątków w klastrze.

Technologia Multi-Instance GPU (MIG) drugiej generacji

Dzięki MIG, wprowadzonemu wcześniej w Ampere, GPU można podzielić na kilka mniejszych, w pełni izolowanych instancji z własną pamięcią, pamięcią podręczną i rdzeniami obliczeniowymi. Architektura Hopper dodatkowo usprawnia MIG, obsługując konfiguracje wielu dzierżawców i wielu użytkowników w zwirtualizowanych środowiskach w maksymalnie siedmiu bezpiecznych instancjach GPU, bezpiecznie izolując każdą instancję za pomocą poufnych obliczeń na poziomie sprzętu i hyperwizora. Dedykowane dekodery wideo dla każdej instancji MIG zapewniają bezpieczną, wysokoprzepustową inteligentną analizę wideo (IVA) we współdzielonej infrastrukturze. Dzięki równoczesnemu profilowaniu MIG Hoppera administratorzy mogą monitorować odpowiednią akcelerację GPU i optymalizować alokację zasobów dla użytkowników. Badacze z mniejszymi obciążeniami, zamiast wynajmować pełną instancję CSP, mogą zdecydować się na użycie MIG w celu bezpiecznego odizolowania części procesora graficznego, mając jednocześnie pewność, że ich dane są bezpieczne w stanie spoczynku, podczas przesyłania i podczas obliczeń.

Nowa obsługa poufnych obliczeń

Dzisiejsze poufne rozwiązania obliczeniowe są oparte na CPU, które są zbyt ograniczone w przypadku obciążeń wymagających dużej mocy obliczeniowej, takich jak sztuczna inteligencja i HPC. NVIDIA Confidential Computing to wbudowana funkcja bezpieczeństwa architektury NVIDIA Hopper, dzięki której NVIDIA H100 jest pierwszym na świecie akceleratorem z możliwościami poufnych obliczeń. Użytkownicy mogą chronić poufność i integralność swoich danych i używanych aplikacji, korzystając jednocześnie z niezrównanej akceleracji GPU H100. Tworzy sprzętowe zaufane środowisko wykonawcze (TEE), które zabezpiecza i izoluje całe obciążenie działające na pojedynczym procesorze graficznym H100, wielu procesorach graficznych H100 w węźle lub poszczególnych instancjach MIG. Aplikacje akcelerowane przez GPU mogą działać bez zmian w TEE i nie muszą być partycjonowane. Użytkownicy mogą połączyć moc oprogramowania NVIDIA dla AI i HPC z bezpieczeństwem sprzętowego źródła zaufania oferowanego przez NVIDIA Confidential Computing.

Pamięć HBM3

H100 NVL wprowadza ogromne ilości mocy obliczeniowej do centrów danych. Aby w pełni wykorzystać tę wydajność obliczeniową, karta NVIDIA H100 NVL wykorzystuje pamięć HBM3 z wiodącą w swojej klasie przepustowością pamięci wynoszącą ponad 3,9 TB/s, co stanowi wzrost o 100 procent w porównaniu z poprzednią generacją. Oprócz 94 GB pamięci HBM3, H100 NVL zawiera 50 MB pamięci podręcznej L2, która umożliwia lepszą wydajność w aplikacjach takich jak głębokie uczenie i symulacje naukowe .

NVIDIA NVLink czwartej generacji

Zapewnia 3-krotny wzrost przepustowości w operacjach all-reduce i 50% ogólny wzrost przepustowości w stosunku do poprzedniej generacji NVLink z całkowitą przepustowością 600 GB/s dla wielu procesorów graficznych IO pracujących z prawie 5-krotnie większą przepustowością niż szyna PCIe Gen 5.

PCIe Gen5 dla najnowocześniejszych procesorów i jednostek DPU

H100 NVL to pierwszy procesor graficzny firmy NVIDIA obsługujący PCIe Gen5, zapewniający najwyższą możliwą prędkość 128 GB/s (dwukierunkowo). Ta szybka komunikacja zapewnia optymalną łączność z najwydajniejszymi CPU, a także z kartami NVIDIA ConnectX-7 SmartNIC i BlueField-3 DPU, które umożliwiają przyspieszenie sieci Ethernet do 400 Gb/s lub NDR 400 Gb/s InfiniBand w celu zapewnienia bezpiecznych obciążeń HPC i sztucznej inteligencji.

Gotowy do zastosowania w przedsiębiorstwie: oprogramowanie AI usprawnia opracowywanie i wdrażanie

Wdrażanie sztucznej inteligencji w przedsiębiorstwach jest obecnie głównym nurtem, a organizacje wymagają kompleksowej infrastruktury gotowej na sztuczną inteligencję, która sprawdzi się w przyszłości w tej nowej erze. Procesory graficzne NVIDIA H100 do serwerów głównego nurtu (PCIe) są dostarczane wraz z pakietem programowym NVIDIA AI Enterprise, dzięki czemu sztuczna inteligencja jest dostępna dla niemal każdej organizacji, oferując najwyższą wydajność w zakresie uczenia, wnioskowania i analizy danych. NVIDIA AI Enterprise wraz z NVIDIA H100 upraszcza budowanie platformy gotowej do sztucznej inteligencji, przyspiesza rozwój i wdrażanie sztucznej inteligencji dzięki obsłudze klasy korporacyjnej oraz zapewnia wydajność, bezpieczeństwo i skalowalność, aby szybciej gromadzić informacje i szybciej osiągać wartość biznesową.

|

Cechy GPU | NVIDIA H100 NVL |

|---|---|---|

| Liczba rdzeni CUDA | 14592 | |

| Liczba rdzeni tensorowych | 456 (Gen 4) | |

| Liczba rdzeni RT | – | |

| Pamięć GPU | 80 GB HBM2e z korekcją błędów (ECC) | |

| Interfejs pamięci | 5120-bitowy | |

| Przepustowość pamięci | 3,9 TB/s | |

| Wyjścia na wyświetlacze | – | |

| Maks. pobór mocy | 350 – 400 W (konfigurowany) | |

| Szyna grafiki | PCIe Gen 5.0 | 128 GB/s | |

| Form Factor | 111,2 mm H x 268,6 mm L, dual slot | |

| Chłodzenie | Pasywne | |

| NVLink | 2-drożny mostek o niskim profilu na 2 sloty łączący 2 karty H100, transfer do 600 GB/s | |

| NVIDIA AI Enterprise | Tak |

SKU: TCSH100NVLPCIE-PB

EAN: 3536403396305

Zawartość:

- Karta NVIDIA H100 NVL