NVIDIA – Narzędzia i ekosystem

Poprawa przenoszenia danych i dostępu do GPU

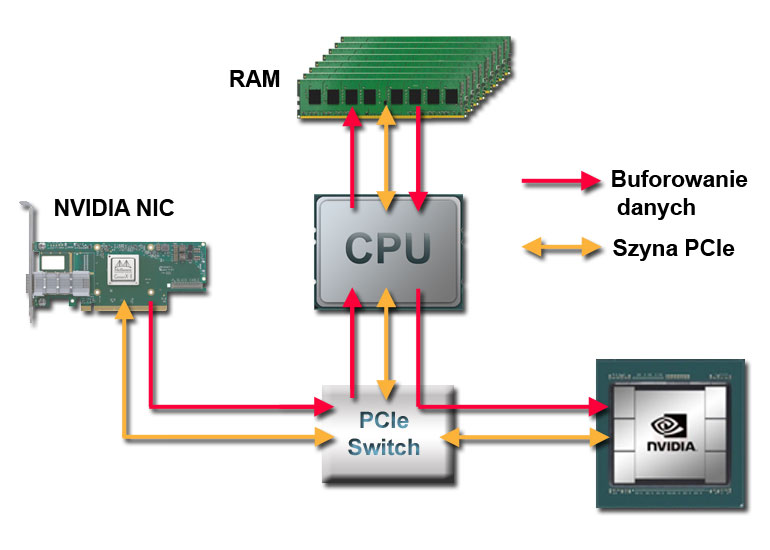

Przy trenowaniu sieci neuronowych czy modelowaniu rynków finansowych istnieje potrzeba zastosowania platformy obliczeniowej o możliwie najwyższej przepustowości danych. Procesory graficzne (GPU) zużywają dane znacznie szybciej niż procesory jednostek centralnych (CPU), a wraz ze wzrostem mocy obliczeniowej GPU rośnie zapotrzebowanie na przepustowość danych.

Kluczowe technologie

NVIDIA GPUDirect

NVIDIA GPUDirect to rodzina technologii firmy NVIDIA wchodząca w skład Magnum IO, która usprawnia przenoszenie danych i dostęp dla procesorów graficznych NVIDIA. Korzystając z GPUDirect, karty sieciowe i napędy pamięci masowej mają bezpośredni dostęp do pamięci GPU przy odczycie i zapisie danych, eliminując niepotrzebne kopie pamięci, zmniejszając obciążenie CPU i zmniejszając opóźnienia, co skutkuje znaczną poprawą wydajności.

Technologie te — w tym GPUDirect Storage, GPUDirect Remote Direct Memory Access (RDMA), GPUDirect Peer to Peer (P2P) i GPUDirect Video — są prezentowane za pośrednictwem kompleksowego zestawu interfejsów API.

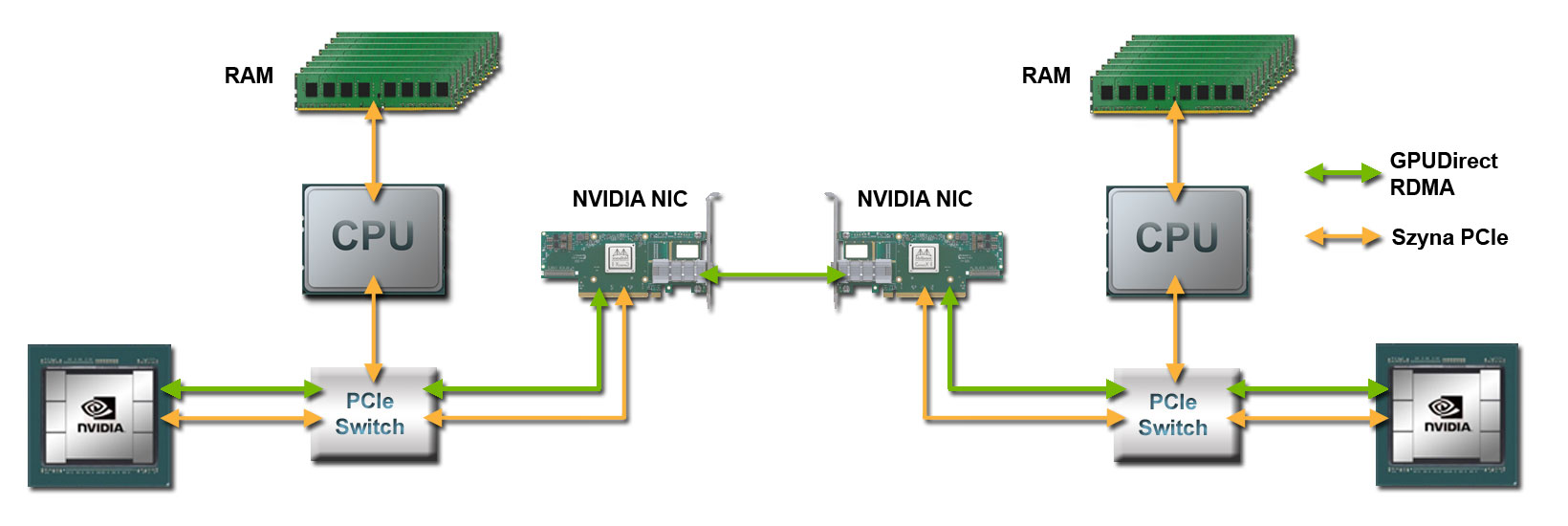

GPU-Direct RDMA

Najnowszym postępem w komunikacji GPU-GPU jest GPUDirect RDMA. Ta technologia zapewnia bezpośrednią ścieżkę danych P2P (Peer-to-Peer) między pamięcią GPU bezpośrednio do lub z kart sieciowych NVIDIA. Zapewnia to znaczne zmniejszenie opóźnień w komunikacji GPU-GPU i całkowicie odciąża CPU, usuwając go z całej komunikacji GPU-GPU w sieci. GPU Direct wykorzystuje możliwości PeerDirect RDMA i PeerDirect ASYNC™ kart sieciowych NVIDIA. Wynikiem zastosowania GPUDirect RDMA jest dziesięciokrotnie lepsza wydajność.

GPUDirect RDMA jest dostępny w pakiecie CUDA Toolkit. Sterowniki urządzeń sieciowych, które zapewniają obsługę GPUDirect RDMA dostępne są u producentów sprzętu.

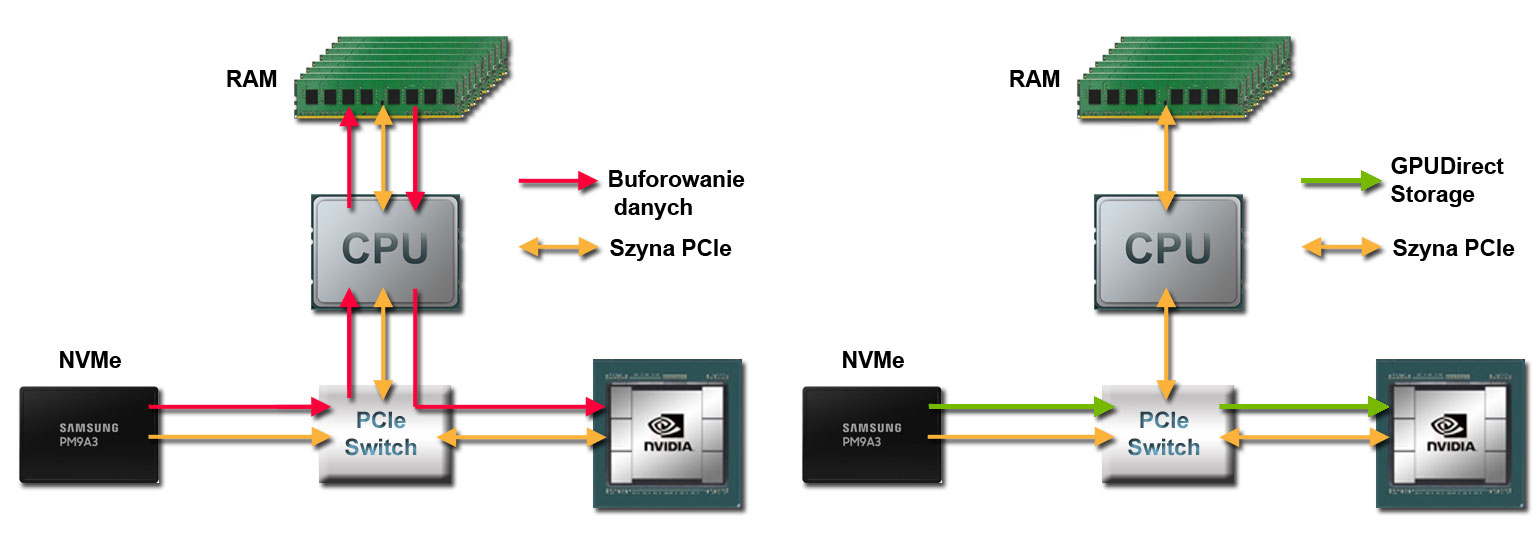

GPU-Direct Storage

Wraz ze wzrostem rozmiaru zestawów danych czas poświęcony na ładowanie danych może wpłynąć na wydajność aplikacji. GPUDirect Storage tworzy bezpośrednią ścieżkę między pomiędzy lokalną lub zdalną pamięcią masową, taką jak NVMe lub NVMe over Fabrics (NVMe-oF) i pamięcią GPU. Włączając silnik bezpośredniego dostępu do pamięci (DMA) w pobliżu karty sieciowej lub pamięci masowej, przenosi dane do lub z pamięci GPU — bez obciążania CPU.

GPUDirect Peer to Peer

Umożliwia kopiowanie danych z GPU do GPU, a także ich ładowanie i przechowywanie z wykorzystaniem PCIe i NVLink. GPUDirect Peer to Peer jest natywnie obsługiwany przez sterownik CUDA. Deweloperzy powinni używać najnowszego zestawu narzędzi CUDA i sterowników w systemie z co najmniej dwoma kompatybilnymi urządzeniami.

GPUDirect dla wideo

Oferuje zoptymalizowany algorytm przesyłania danych dla urządzeń opartych na klatkach, takich jak frame grabbery, przełączniki wideo, urządzenia do przechwytywania HD-SDI i urządzeń typu CameraLink, aby efektywnie przesyłać klatki wideo do lub z pamięci GPU NVIDIA:

- Pozwala uniknąć tworzenia niepotrzebnych kopii danych w pamięci systemowej i odciążyć CPU, kopiując dane przez przypiętą pamięć hosta.

- Synchronizacja transferów pozwala GPU i urządzeniom we/wy wideo współpracować ze sobą bez sztucznych stanów oczekiwania na zakończenie zadania.

- Zmniejsza opóźnienia, przesyłając mniejsze fragmenty danych, zamiast czekać na zakończenie całego pola lub ramki.

Funkcjonalność dostępna tylko w systemie Windows.